Edge-augmented Graph Transformers: Global Self-attention is Enough for Graphs(EGT)

Published:

Edge-augmented Graph Transformers: Global Self-attention is Enough for Graphs [SIGKDD2022]

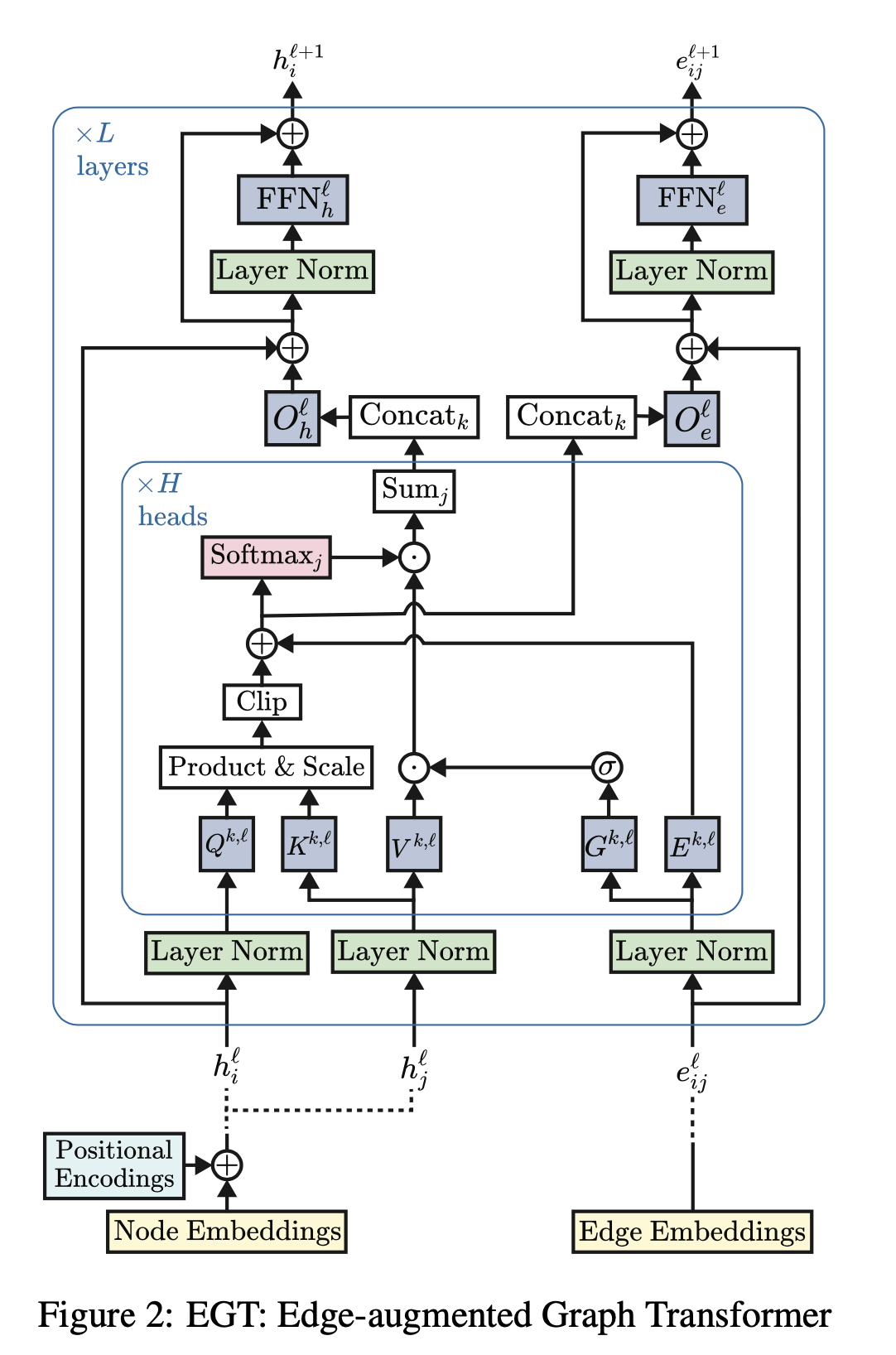

- EGT是直接对图应用全局自注意力

- 可以直接接受、处理和输出结构信息以及节点信息

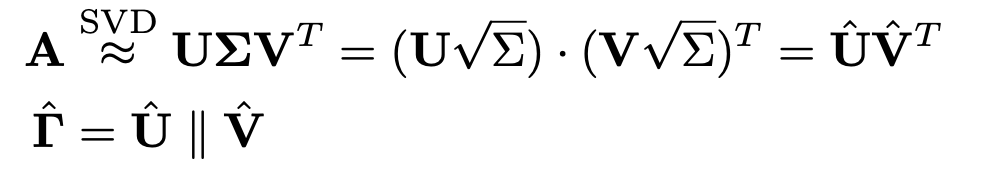

- 位置编码是基于奇异值分解的图的广义编码方案

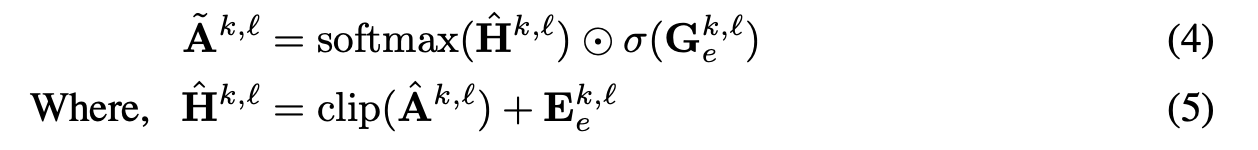

上述公式中的E和G,都是edge embedding得到的,将其加到base transformer的聚合过程中,相当于让edge channel也参与到聚合过程。

第一个式子将邻接矩阵进行SVD分解,再拆解成 $\hat{U}, \hat{V}$从而得到$\hat{\Gamma}$ ,$\hat{\Gamma}$的每一行包含了edge去噪(denoised)的信息,所以能用作位置编码。($\hat{U}的第i行,\hat{V}的第j行$的点积可以近似邻接矩阵$A_{ij}$)。【不是很懂为什么就包含了edge去噪以后的信息】

实验部分: 作者是在supervised and inductive setting下评估EGT的性能。主要做了node classfication, edge classfication, graph classification and regress.